La dernière version de la community edition (basée sur la version commerciale AOS 5.18) étant sortie depuis un petit moment comme j’ai pu l’évoquer ici ou là, j’ai tenté d’installer cette version sur un NUC8i5BEH. L’objectif de cet article est de vous relater mon expérience dans cette installation qui ne s’est pas produite sans embuches.

L’installation bare-metal

Au tout début, j’avais opté pour installer la CE en bare-metal sur un NUC8i5BEH avec le nouveau mode d’installation via ISO bootable que fournit Nutanix en 5.18.

Je créé donc une clé USB2 bootable avec le traditionnel outil rufus et boot dessus. Là, les prermiers problèmes apparaîssent à la création de la CVM …

Après plusieurs tentatives, l’erreur suivante persiste :

Le NUC semble tout de même respecter les pré-requis et passer les pre-checks.

J’en profites pour mettre à jour le BIOS de mon NUC en toute dernière version.

Malgré plusieurs recherches sur le bien aidant forum Nutanix, je ne parviens à corriger cet erreur et opte pour une autre « première » solution.

L’installation bare-metal plan B

Voulant à tout pris installer en bare-metal la CE sur mon NUC, et profiter de l’intégralité des ressources de ce dernier, je persiste dans cette voie.

La CE étant tout juste sortie en 5.18, et l’ISO nouveau, je choisis d’opter pour l’installation avec la méthode img, toujours en utilisant le célèbre Rufus pour créer ma clé bootable.

Ici, le petit incovénient est que la dernière version d’img n’est pas basé sur 5.18 mais plutôt 5.15 puisqu’elle est extraite de l’avant dernière version de la CE. Ce qui n’est pas grave, je tenterais un upgrade ensuite.

En voulant booter sur la clé en img, cette dernière n’est pas visible dans le BIOS de mon NUC. Après plusieurs changements de clé, ce dernier semble ne vouloir booter en legacy uniquement sur des clés USB 2.

Je lance donc l’installation sur cette dernière et tout se passe bien dans le process.

Mais là, c’est le drame …

Voulant, vérifier l’installation de mon cluster, je tente de pinger ma CVM, cette dernière n’est pas reachable. Je me connecter sur l’hôte qui lui semble OK, et avec un petit « virsh list –all » peut voir que ma CVM est correctement démarré. Je lance des pings depuis mon hyperviseur, vers l’ip locale de ma CVM et sur le réseau interne Nutanix (192.168.5.254) et me rends compte que cette dernière ne réponds sur aucune de ces interfaces.

Je relance l’installation et là toujours le même problème.

Après plusieurs recherches sur le forum, plusieurs postes semble mentionner ce problème sans le solutionner.

J’abandonne donc mon idée première, et change de voie…

L’installation sur vSphere ESXi 7.0 valeur sûre

Sans solution, avec mon matériel actuel et les versions de community edition à disposition, je choisis donc la solution ultime de virtualiser ma CE.

Inconvénients de cette option :

- Je suis obliger d’installer un hyperviseur ESXi

- Je ne vais pas pouvoir du coup profiter de mes ressources, et sur un LAB, avec une CVM à 16Go et une PCVM à peut prêt identique, la mémoire ca se compte…

Avantages :

- Je peux monter l’ISO d’installation, et n’ai pas besoin de réinstaller ma clé si l’installation échoue

- Je peux utiliser un boot disk SSD virtuel au lieu d’une clé USB (le NUC ne peut accueillir que deux disques si j’étais en bare-metal, donc media de boot amovible)

J’installe donc en bare-metal mon ESXi 7.0 Update 1 sur le NUC. Bon là, premier soucis, la carte réseau du NUC n’est pas reconnue.

Après plusieurs lectures, il semble que celà fonctionne en 7.0.0 mais pas dans les updates suivantes …

Je réinstalle en 7.0.0 (même si une injection de drivers sur un 7.0 U1 aurait pu être possible).

Je suis prêt à créer ma VM Nutanix CE.

Voici la configuration appliquée :

Une machine CentOS 7 (compatibilité ESXi 7.0) avec :

- 2 vCPU 2 cores (avec l’activation de l’option : « Virtualisation matérielle > Exposer l’assistance matérielle à la virtualisation au SE invité » d’activée)

- 50 Go de mémoire vive (Pour l’hôte AHV, ma CVM à 16Go, et une Prism Central VM)

- Un disque de 64 Go pour le bootmedia

- Un disque de 250 Go pour la CVM

- Un disque de 500 Go pour les Datas

- Un CD ROM pour monter l’ISO

- Une vNIC

Je suis enfin prêt à lancer l’installation, et jusqu’à la création de la CVM tout se passe bien…

Ensuite sans terminée, l’installation la VM reboot en boucle.

Pour en avoir le coeur net, je tente une ultime solution, mettre à jour l’ESXi en 7.0 U1.

Pour celà, je suis obliger de prendre quelques précautions pour ne pas perdre la compatibilité de ma carte réseau.

Voici les étapes réalisées :

- Suppression du vmkusb-nic-fling incompatible avec la mise à jour :

-

esxcli software vib remove -n vmkusb-nic-fling

- Update en 7.0 u1 :

esxcli software profile update -p ESXi-7.0.1-16850804-standard -d /vmfs/volumes/YOURDATASTORE/VMware-ESXi-7.0U1-16850804-depot.zip

- (Ici, j’ai du activé la swap car l’update ne voulait pas passer sur mon infrastructure vSphere : Hôte > gérer > Echange 🙂

- Avant le redémarrage de l’hôte, je downgrade le driver réseau :

-

esxcli software vib install -n ne1000:0.8.4-10vmw.700.1.0.15843807 -d https://hostupdate.vmware.com/software/VUM/PRODUCTION/main/vmw-depot-index.xml

Fin des embûches ou presque …

Mon hyperviseur à jour, je relance mon processus d’installation de ma CE.

Le processus d’installation se passe relativement bien mais la CVM est inaccessible depuis son ip « externe ».

Enfait, pour de la Nested virtualisation il faut activer le mode Promiscuous sur le vSwitch.

Pour le faire (Gestion de l’hôte > Réseau > Commutateurs virtuels )

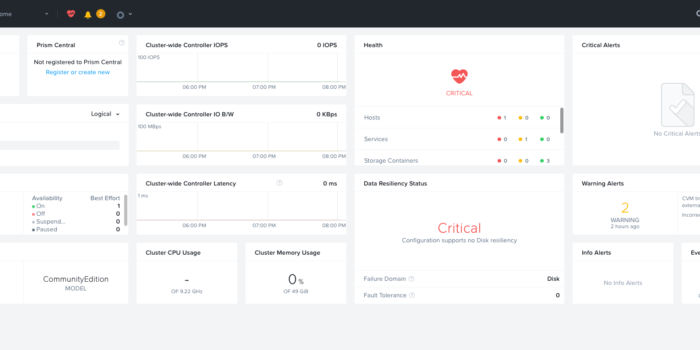

A partir de ce moment, l’installation est pleinement fonctionnelle …

Bravo Théo

Super Tuto, si tu arrives l’installer en barre métal sur un NUC10** je suis preneur